项目简介

AniPortrait是腾讯刚开源的一个项目,通过音频驱动技术合成逼真的人像动画。这项技术使得根据音频输入,可以生成高度真实的人脸表情和动作,为多种应用场景提供了新的可能性,包括但不限于虚拟现实、游戏、在线会议等。项目完全使用Python开发,遵循Apache-2.0许可证。这不仅是技术的一次飞跃,也为艺术创作和多媒体展示开辟了新的路径

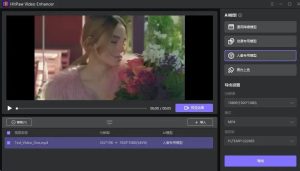

管道

![图片[1]-AniPortrait:腾讯最新开源音频合成逼真人脸动画项目,一起看下跟SunoAI音乐结合的效果-爆品运营狮](https://bpyys.top/wp-content/uploads/2024/04/frc-ed02555d29cc73b685a9a8e7b02ea093.png)

安装

1.搭建环境

推荐 python 版本 >=3.10 和 cuda 版本 =11.7。然后搭建环境如下:

pip install -r requirements.txt2.下载权重

所有的权重文件应该被放置在 ./pretrained_weights 目录下。

您可以按照以下方式手动下载权重:

下载我们训练好的权重,包括四个部分:

denoising_unet.pth、reference_unet.pth、pose_guider.pth、motion_module.pth 和 audio2mesh.pt。

下载基于模型和其他组件的预训练权重:

·StableDiffusion V1.5

https://huggingface.co/runwayml/stable-diffusion-v1-5

·sd-vae-ft-mse

https://huggingface.co/stabilityai/sd-vae-ft-mse

·image_encoder

https://huggingface.co/lambdalabs/sd-image-variations-diffusers/tree/main/image_encoder

·wav2vec2-base-960h

https://huggingface.co/facebook/wav2vec2-base-960h

最后,这些权重应该按照以下方式组织:

./pretrained_weights/|-- image_encoder| |-- config.json| `-- pytorch_model.bin|-- sd-vae-ft-mse| |-- config.json| |-- diffusion_pytorch_model.bin| `-- diffusion_pytorch_model.safetensors|-- stable-diffusion-v1-5| |-- feature_extractor| | `-- preprocessor_config.json| |-- model_index.json| |-- unet| | |-- config.json| | `-- diffusion_pytorch_model.bin| `-- v1-inference.yaml|-- wav2vec2-base-960h| |-- config.json| |-- feature_extractor_config.json| |-- preprocessor_config.json| |-- pytorch_model.bin| |-- README.md| |-- special_tokens_map.json| |-- tokenizer_config.json| `-- vocab.json|-- audio2mesh.pt|-- denoising_unet.pth|-- motion_module.pth|-- pose_guider.pth`-- reference_unet.pth

推理 以下是运行推理脚本的命令行命令: 请注意,你可以在命令中设置 -L 为所需的生成帧数,例如,-L 300。

·自驱动

你可以参考 animation.yaml 的格式来添加您自己的参考图像或姿势视频。要将原始视频转换为姿势视频(关键点序列),可以使用以下命令运行:

·面部重构 在animation_facereenac.yaml中添加源人脸视频和参考图像。

·音频驱动 在 animation_audio.yaml 中添加音频和参考图像。 你可以使用此命令生成一个用于头部姿势控制的 pose_temp.npy:python -m scripts.pose2vid --config ./configs/prompts/animation.yaml -W 512 -H 512python -m scripts.vid2pose --video_path pose_video_path.mp4python -m scripts.vid2vid --config ./configs/prompts/animation_facereenac.yaml -W 512 -H 512python -m scripts.audio2vid --config ./configs/prompts/animation_audio.yaml -W 512 -H 512python -m scripts.generate_ref_pose --ref_video ./configs/inference/head_pose_temp/pose_ref_video.mp4 --save_path ./configs/inference/head_pose_temp/pose.npy

项目链接 https://github.com/Zejun-Yang/AniPortrait

暂无评论内容